提取网页所有链接的方法

在现代网络浏览和信息检索的过程中,获取网页中的全部链接是一个常见的需求。无论你是出于研究目的、数据分析还是仅仅想整理一些参考资料,学会如何高效地提取网页中的链接都是一项非常实用的技能。以下将介绍几种主要的方法,包括使用浏览器扩展、编程语言和在线工具,来帮助你轻松获取网页中的全部链接。

一、使用浏览器扩展

1. Link Gopher

Link Gopher是一款非常流行的Chrome和Firefox扩展,专门用于提取网页上的所有链接。安装完成后,只需点击扩展图标,它便会在新标签页中列出当前页面上的所有链接,包括文本链接、图片链接和隐藏的链接。此外,Link Gopher还提供了过滤功能,你可以根据需求只显示特定类型的链接,比如只显示图片链接或只显示外部链接。

2. Link Clump

Link Clump是另一个强大的浏览器扩展,支持Chrome和Firefox。它的特点是能够让你通过鼠标手势快速选择和提取网页上的链接。安装后,你可以在网页上按住右键并拖动鼠标,画出一个矩形框,框内的所有链接将被自动提取并显示在弹出窗口中。你可以选择复制这些链接,或在新标签页中打开它们。

3. Check My Links

虽然Check My Links的主要功能是检查网页上的链接是否有效,但它也能帮助你提取网页上的所有链接。这个扩展在Chrome和Firefox中都可以使用。安装后,只需点击扩展图标,它便开始扫描页面上的所有链接,并在弹出窗口中列出结果。虽然它主要显示链接的有效性,但你可以通过简单的复制粘贴来获取所有链接。

二、使用编程语言

如果你熟悉编程,那么使用编程语言如Python来提取网页中的链接将是一个更加灵活和强大的选择。以下将介绍几种常用的方法和库。

1. 使用BeautifulSoup和Requests库(Python)

BeautifulSoup是一个用于解析HTML和XML文档的Python库,结合Requests库,你可以轻松地从网页中提取链接。

```python

import requests

from bs4 import BeautifulSoup

发送HTTP请求获取网页内容

url = 'http://example.com'

response = requests.get(url)

html_content = response.text

解析HTML内容

soup = BeautifulSoup(html_content, 'html.parser')

提取所有标签的href属性

links = [a.get('href') for a in soup.find_all('a', href=True)]

打印链接

for link in links:

print(link)

```

2. 使用Selenium(Python)

Selenium是一个用于自动化网页测试的工具,但它也可以用来提取网页中的链接。与BeautifulSoup不同,Selenium可以处理JavaScript渲染的内容,这在处理动态网页时非常有用。

```python

from selenium import webdriver

from selenium.webdriver.common.by import By

设置Chrome WebDriver的路径

driver_path = '/path/to/chromedriver'

driver = webdriver.Chrome(executable_path=driver_path)

打开网页

url = 'http://example.com'

driver.get(url)

提取所有标签的href属性

links = [elem.get_attribute('href') for elem in driver.find_elements(By.TAG_NAME, 'a') if elem.get_attribute('href')]

打印链接

for link in links:

print(link)

关闭浏览器

driver.quit()

```

3. 使用Node.js和Cheerio

Cheerio是一个实现了核心jQuery的快速、灵活且高效的库,适用于服务器端的HTML解析。结合Node.js,你可以方便地提取网页中的链接。

```javascript

const axios = require('axios');

const cheerio = require('cheerio');

async function fetchLinks(url) {

const { data } = await axios.get(url);

const $ = cheerio.load(data);

const links = [];

$('a').each((index, element) => {

const href = $(element).attr('href');

if (href) {

links.push(href);

});

return links;

const url = 'http://example.com';

fetchLinks(url).then(links => {

links.forEach(link => {

console.log(link);

});

});

```

三、使用在线工具

如果你不想安装任何软件或扩展,也不想编写代码,那么使用在线工具是一个简单且方便的选择。以下是一些流行的在线工具,可以帮助你提取网页中的链接。

1. Small SEO Tools Link Extractor

Small SEO Tools提供了一个免费的在线链接提取工具,只需输入网页的URL,它便会在几秒钟内提取并显示页面上的所有链接。你可以将结果导出为CSV文件,以便进一步分析。

2. Online Link Extractor

另一个免费的在线工具,它提供了类似的功能。只需输入URL,点击“提取链接”按钮,它便会在新页面显示所有提取的链接。你可以复制这些链接,或将它们保存到本地。

3. LinkMiner

虽然LinkMiner主要是一个SEO工具,用于分析网页上的链接,但它也提供了一个免费的链接提取功能。输入URL后,它将分析页面并显示所有内部和外部链接,以及链接的文本和锚文本。

总结

无论你是普通用户还是开发人员,都有多种方法可以帮助你提取网页中的链接。使用浏览器扩展是最简单和直接的方法,适合偶尔需要提取链接的用户。如果你熟悉编程,那么使用编程语言如Python或Node.js将提供更灵活和强大的功能。如果你不想安装任何软件或编写代码,那么使用在线工具将是一个简单且方便的选择。选择哪种方法取决于你的具体需求和技能水平。希望这篇文章能帮助你快速获取网页中的全部链接。

- 上一篇: QQ怎样设置聊天背景?

- 下一篇: 最新12个微信疯狂骑士团兑换码礼包大放送

-

如何获取网站所有页面链接资讯攻略12-07

如何获取网站所有页面链接资讯攻略12-07 -

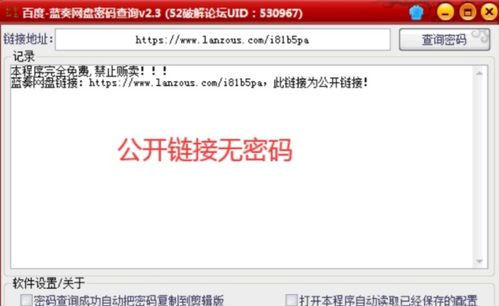

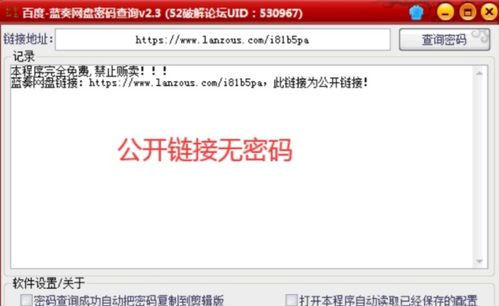

揭秘:轻松获取网盘提取码的高效方法资讯攻略11-25

揭秘:轻松获取网盘提取码的高效方法资讯攻略11-25 -

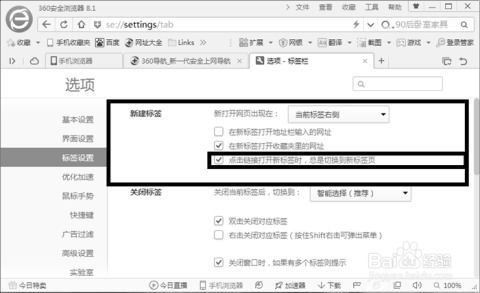

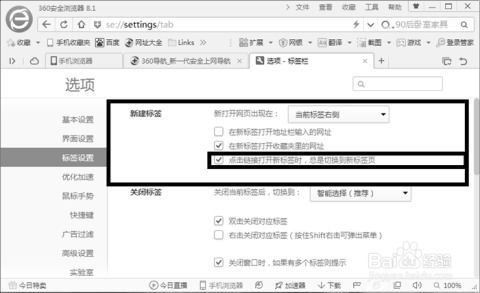

一键直达:点击链接后自动跳转新网页的方法资讯攻略11-18

一键直达:点击链接后自动跳转新网页的方法资讯攻略11-18 -

怎样复制一个网页的链接?资讯攻略12-05

怎样复制一个网页的链接?资讯攻略12-05 -

《Scribble Diffusion》网页版入口链接在哪里?资讯攻略04-05

《Scribble Diffusion》网页版入口链接在哪里?资讯攻略04-05 -

揭秘:百度搜索引擎蜘蛛的高效爬取机制与工作原理资讯攻略11-12

揭秘:百度搜索引擎蜘蛛的高效爬取机制与工作原理资讯攻略11-12